Kafka 的文件存储机制

1. 数据存储形式

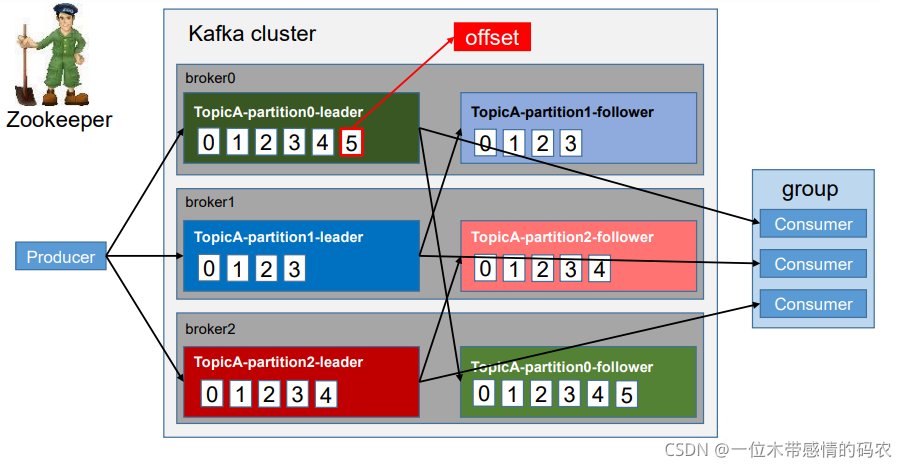

Kafka 中消息是以 topic 进行分类的,生产者生产消息,消费者消费消息,都是面向 topic 的。

topic 是逻辑上的概念,而 partition 是物理上的概念,每个 partition 对应于一个 log 文件,该 log 文件中存储的就是 producer 生产的数据。Producer 生产的数据会被不断追加到该log 文件末端,且每条数据都有自己的 offset。消费者组中的每个消费者,都会实时记录自己消费到了哪个offset,以便出错恢复时,从上次的位置继续消费。

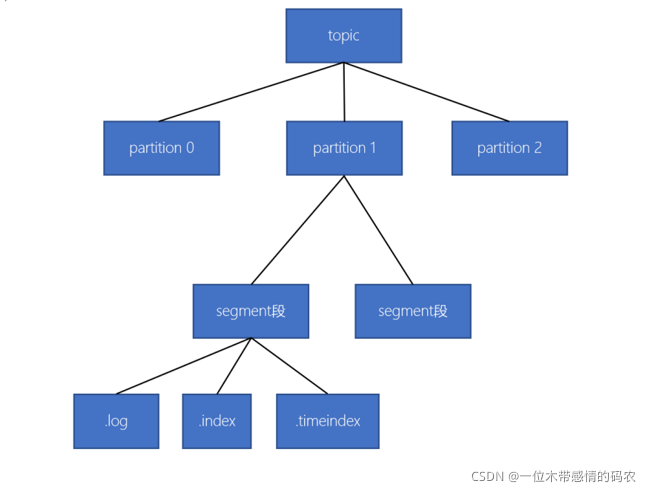

- 一个topic由多个分区组成

- 一个分区(partition)由多个 segment(段)组成

- 一个 segment(段)由多个文件组成(log、index、timeindex)

2. 日志文件

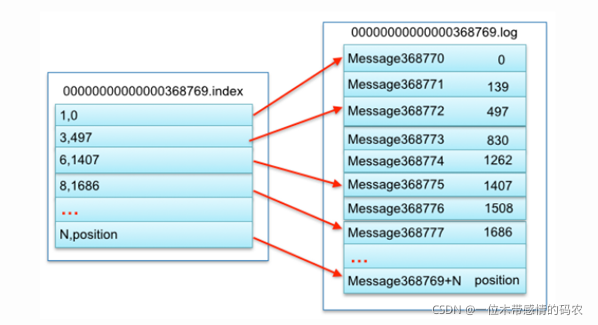

由于生产者生产的消息会不断追加到 log 文件末尾,为防止 log 文件过大导致数据定位效率低下,Kafka 采取了分片和索引机制,将每个 partition 分为多个 segment。

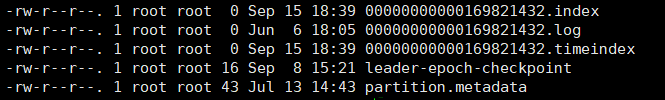

每个 segment 对应三个文件——“.index”文件、“.log”文件和“.timeindex”文件。这些文件位于一个文件夹下,该文件夹的命名规则为:topic名称+分区序号。例如,first 这个 topic 有三个分区,则其对应的文件夹为 first- 0,first-1,first-2,数据文件夹总包含以下内容:

| 文件名 | 说明 |

|---|---|

| 00000000000169821432.index | 索引文件,根据offset查找数据就是通过该索引文件来操作的 |

| 00000000000169821432.log | 日志数据文件 |

| 00000000000169821432.timeindex | 时间索引 |

| leader-epoch-checkpoint | 持久化每个partition leader对应的LEO(log end offset、日志文件中下一条待写入消息的offset) |

| partition.metadata | 分区的元数据 |

- 每个日志文件的文件名为起始偏移量,因为每个分区的起始偏移量是0,所以,分区的日志文件都以

0000000000000000000.log开始 - 默认的每个日志文件最大为

「log.segment.bytes=1024*1024*1024」1G - 为了简化根据offset查找消息,Kafka日志文件名设计为开始的偏移量

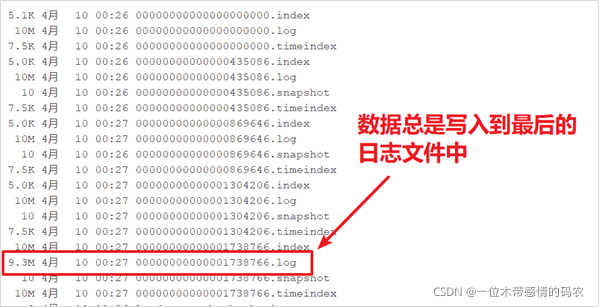

3. 写入消息

- 新的消息总是写入到最后的一个日志文件中

- 该文件如果到达指定的大小(默认为:1GB)时,将滚动到一个新的文件中

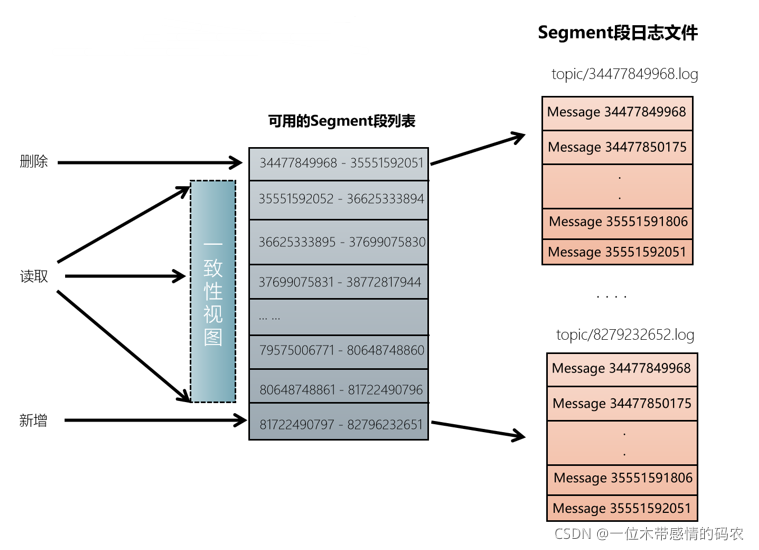

4. 读取消息

- 根据「offset」首先需要找到存储数据的 segment 段(注意:offset指定分区的全局偏移量)

- 然后根据这个「全局分区offset」找到相对于文件的「segment段offset」

- 最后再根据 「segment 段 offset」读取消息

- 为了提高查询效率,每个文件都会维护对应的范围内存,查找的时候就是使用简单的二分查找

5. 删除消息

- 在Kafka中,消息是会被定期清理的。一次删除一个segment段的日志文件

- Kafka的日志管理器,会根据Kafka的配置,来决定哪些文件可以被删除

此文章版权归 程序园 所有,如有转载,请注明来自原作者。

评论

ValineDisqus